1. 引言

2. XAI和TAI的基本概念

3. 数据起源, XAI, TAI的文献计量分析

4. 数据起源, XAI, TAI的关系的思考

5. 数据起源, XAI, TAI未来十年发展趋势

6. 结论

-

AI可解释性和可信度的背景

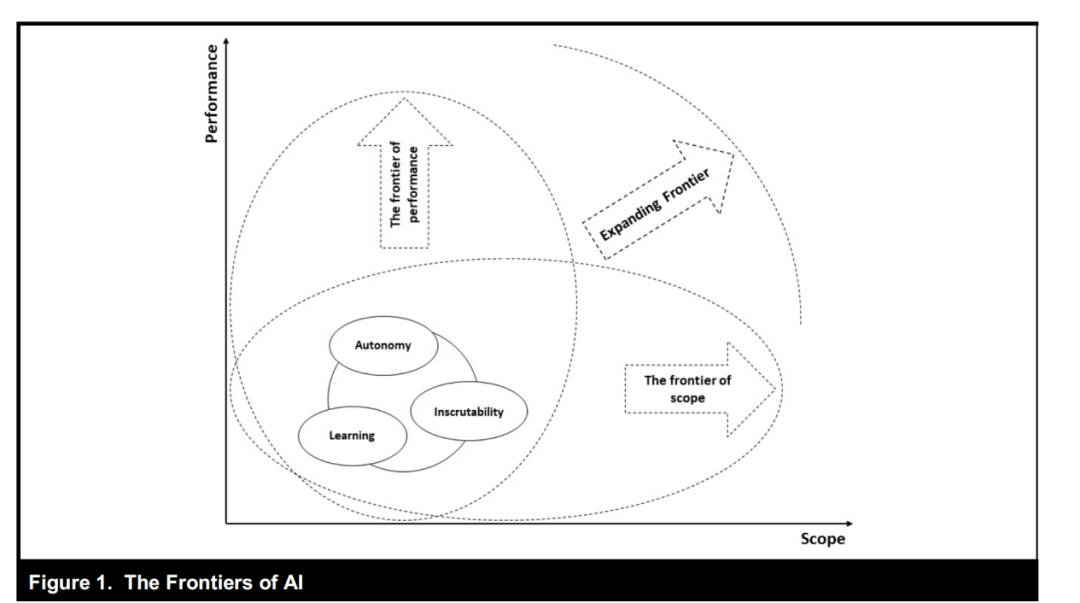

作者先列举了多例AI和机器学习的漏洞证明了提高可解释性的重要。又说明TAl的基本原则是建立合法透明的AI系统。然后列举各个国家在数据科学领域到XAI方法和战略计划,学者Wing扩充了计算机系统的维度,并认为需要权衡多种维度。

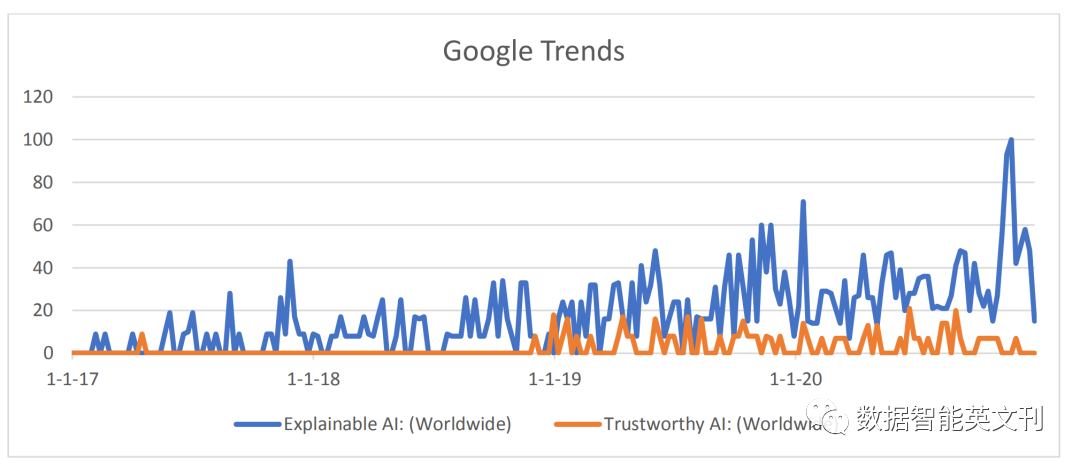

图1 XAI和TAI的谷歌趋势

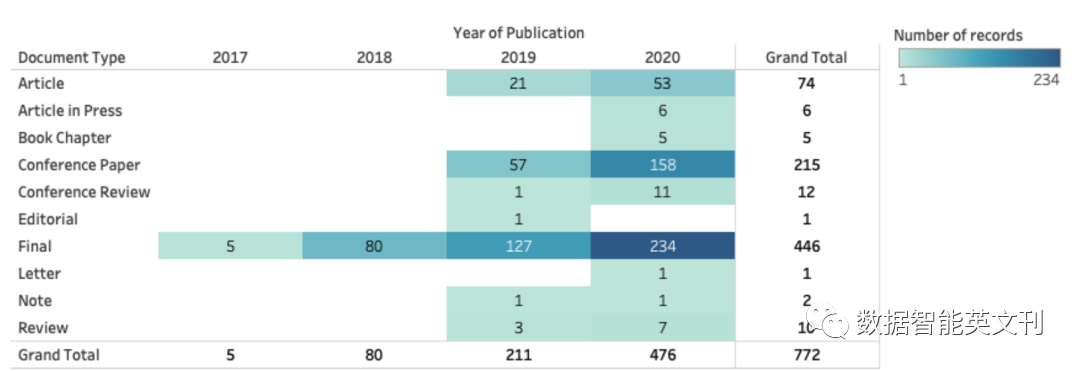

图2 文献库中论文的时间分布

-

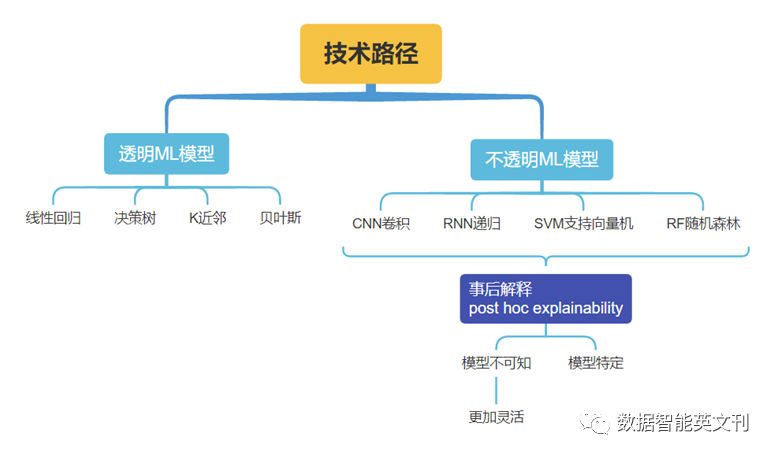

实现XAI和TAI的技术途径

图3 ML模型分类及对应XAI方法

这些方法可以生成结果,但是为了增加AI系统的透明度,需要应用数据起源作为XAI的补充技术。

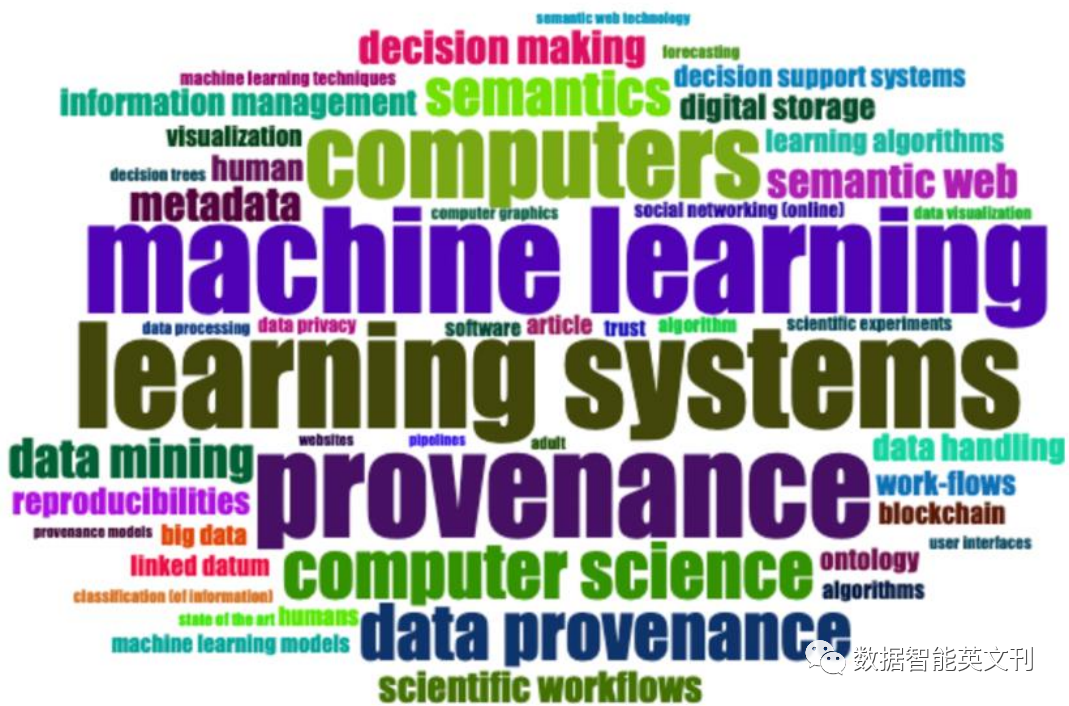

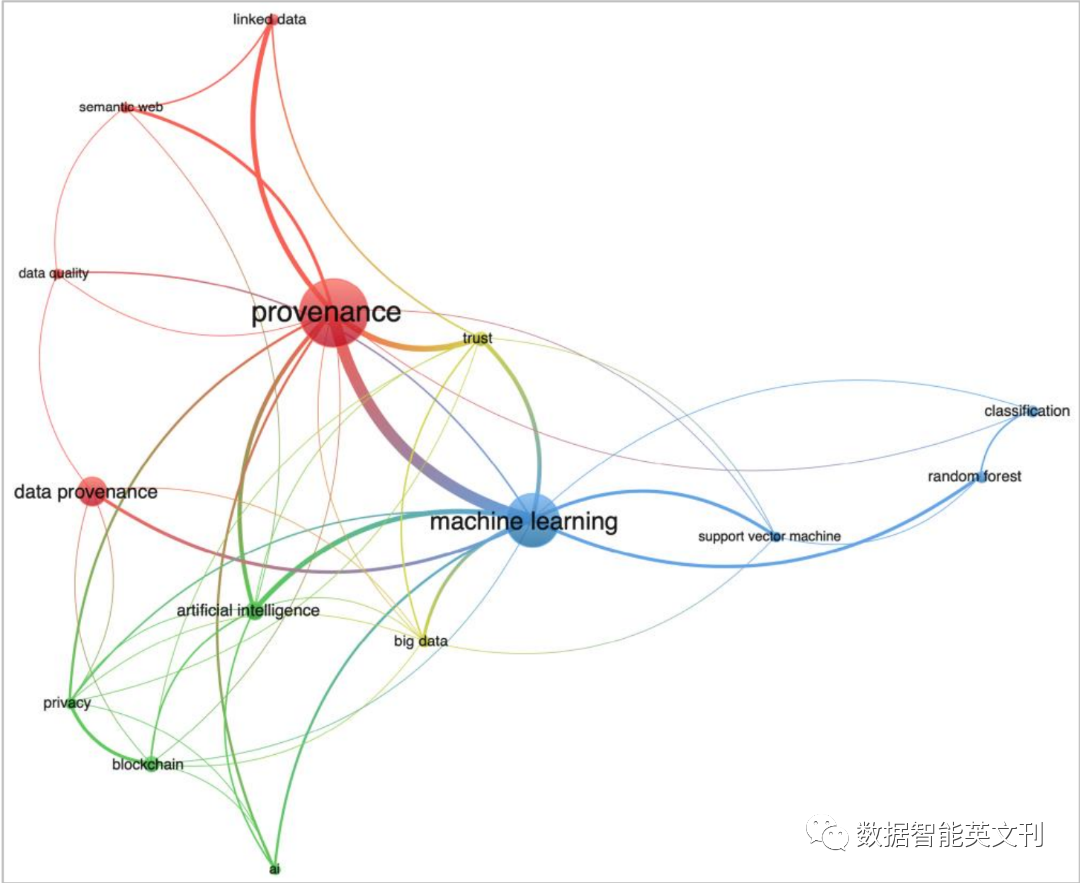

文中进行文献计量分析去搜集这三者之间在论文中相互关联的证据。作者说明选择数据库的原因和查询的关键字以及分析工具是Bibliometrix和VOS Viewer。

图4 参考文献标题中的单词可视化词云

图5 关键词共现图聚类

-

来源标准的关注度和相关工作增加

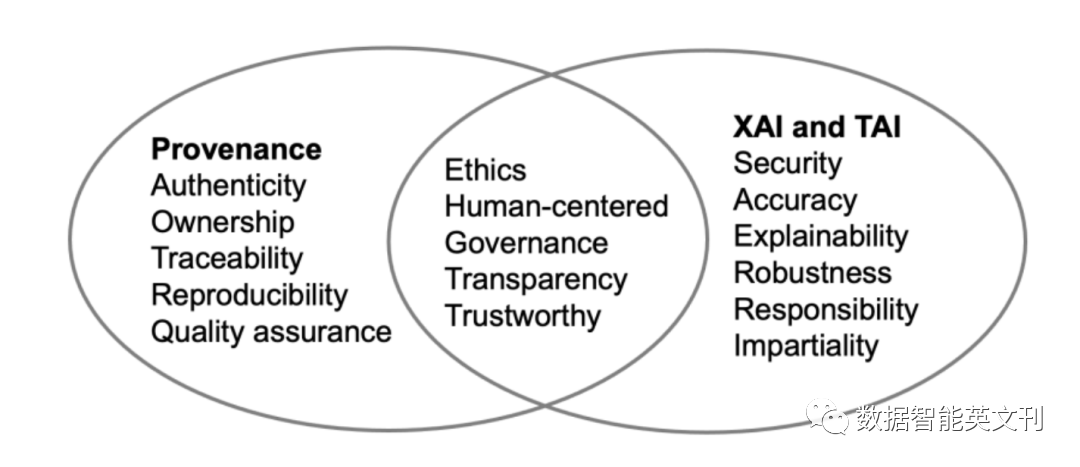

作者进行文献综述,整理研究主题后得出:

图6 三者话题相似度

文中也介绍了一些能够使得Provenance文档化的工具,比如W3C PROV本体,OpenML等。

-

数据起源实践及对XAI和TAI的支持

对于现实世界的实践,作者进行文献综述,讲述数据起源模型类别,W3C PROV的六个组件,然后作者简单介绍Renku等应用工具软件。

本部分讨论了在AI/ML模型中造成偏差的原因,数据不可追踪,没有数据起源支持的决定是不可信的。

这项工作是社会-技术交叉领域问题,需要从两方面解决问题。

开发数据起源功能应用前应掌握用户需求

应开发更多的自动化工具记录数据起源,并将其标准化、使数据起源记录可查询可访问。

用事后解释的方法来解释AI或机器学习模型是不够的,需要数据起源加入增加系统可信度和透明度。作者总结了文章行文顺序,强调数据起源对于XAI和TAI的重要性。

ai论文写作

ai论文写作

评论前必须登录!

立即登录 注册