千呼万唤始出来,马毅教授的AI综述论文终于出炉!

耗时三个多月,联合神经科学家曹颖、计算机大牛沈向洋,协作完成。

据本人描述,这篇论文是将他“过去五年的工作以及智能七十多年的发展有机结合起来”,并且还表示:

一生从未在一篇文章上花这么多精力和时间。

具体而言,就是“理出了智能的起源以及计算原理的基本轮廓和框架,能让大家认识到这种理论联系实践的可能性。”

此前在社交网络上预告时,许多网友都期待十足。

结果今天刚发不久,就有学者表示,正好要设计新的生成模型,给了我灵感。

来看看这是篇怎样的论文?

两大原则:简约和自洽

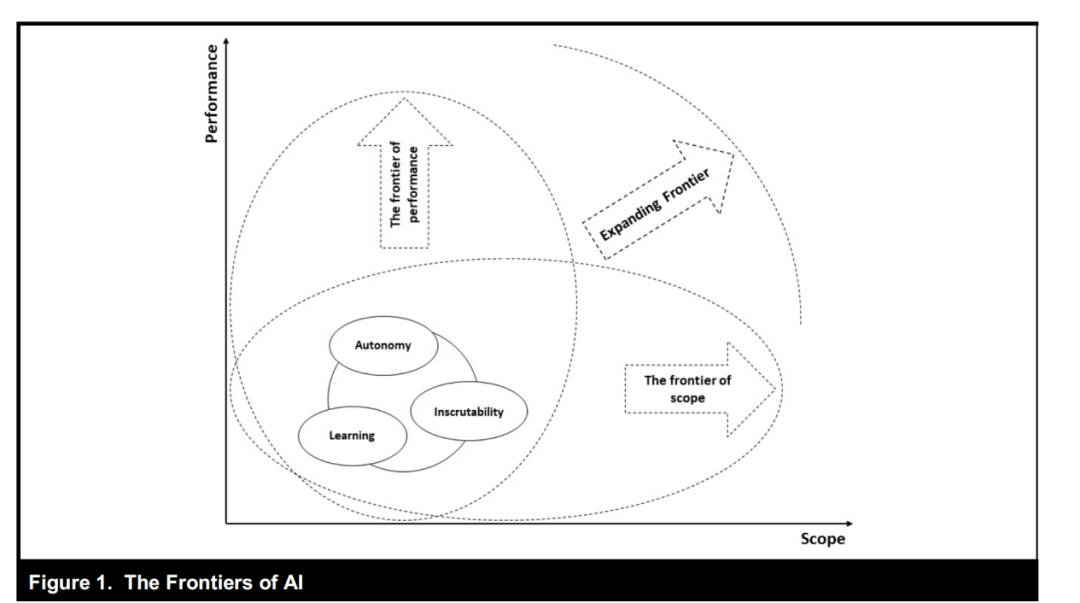

过去十年中,人工智能的进展主要依赖于训练同质化的黑箱模型,决策过程、特征表示等方面在很大程度上都是难以解释的。

而这种端到端的粗暴训练,不仅导致了模型大小、训练数据以及计算成本不断增长,而且在实践中还伴随着许多问题。

学到的表征缺乏丰富性;训练中缺乏稳定性;缺乏适应性,容易出现灾难性遗忘……

基于这样的背景,研究人员假设,在实践中出现这些问题的根本原因之一,是对智能系统的功能和组织原则缺乏系统和综合的理解。

而这背后是否存在一个统一的方法来解释。

为此这篇文章提出了两个基本原则——简约和自洽,分别回答两个关于学习的基本问题。

1、学什么:从数据中学习的目标是什么,如何衡量?

2、如何学:我们如何通过高效和有效的计算来实现这样一个目标?

他们认为这两个原则制约着任何智能系统的功能和设计,而且完全可以以可测量和可计算的方式重新表述。

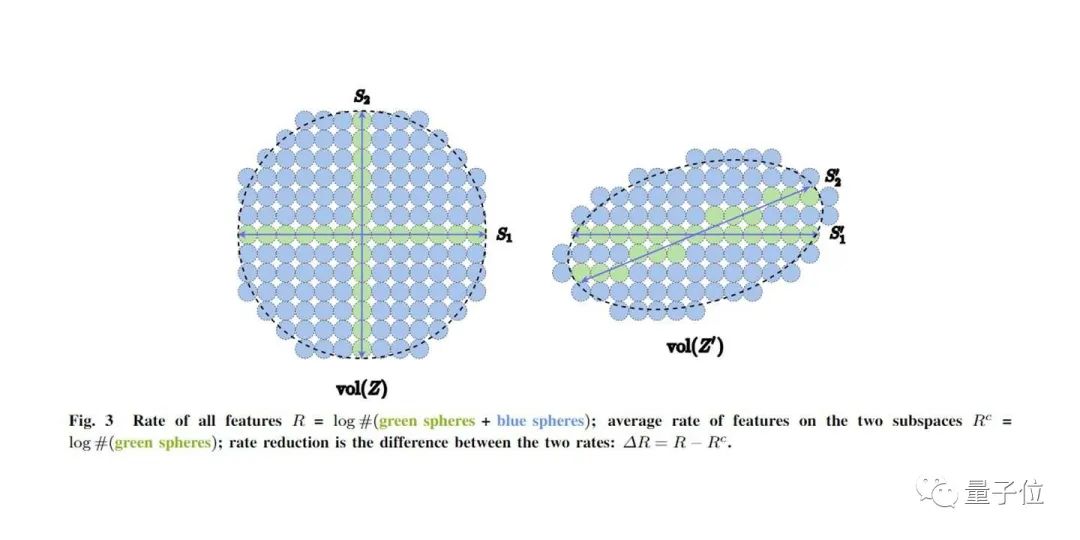

以简约性为例。智能的基础是环境中的低维结构,这让预测和泛化变成可能,这也就是简约原则。而应该如何来度量?本文提出了个几何公式来衡量简约性。

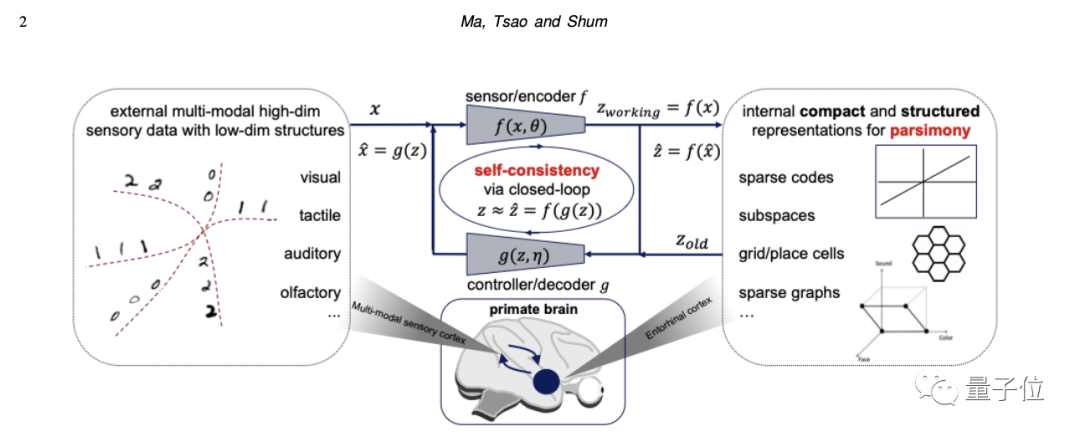

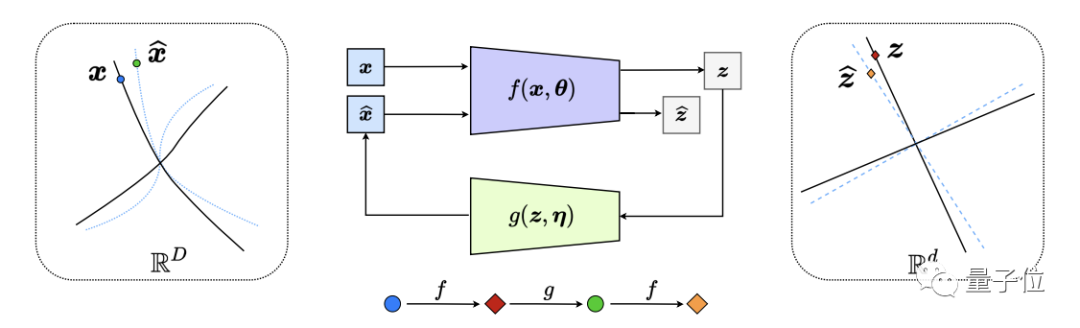

基于这两个原则, 得出了感知/智能的通用架构:压缩器和生成器之间的闭环转录。

它暗示了两者之间的交互应该是一种追逃游戏。在这个游戏中,他们扮演联合目标函数的对立面,而非自动编码器。

这也是此框架的主要优势之一,通过自我监督和自我批判进行自我学习,这是最自然和有效的。

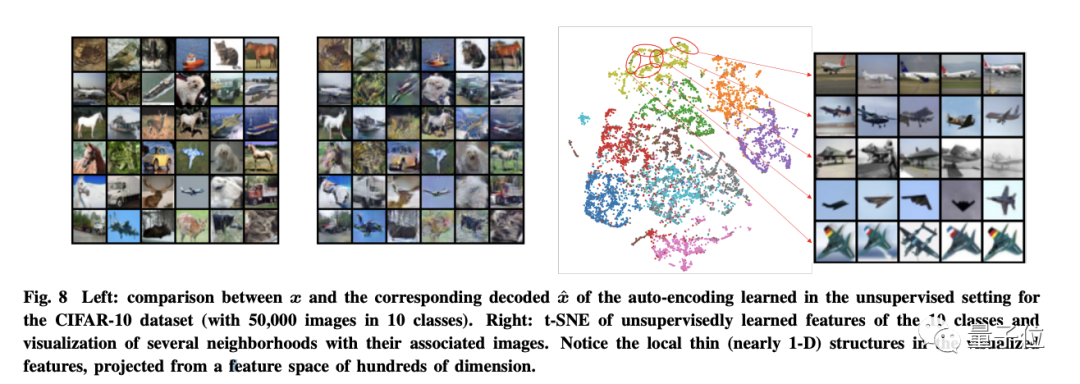

从根本上说,这个框架可以扩展到完全无监督的环境中, 这时候只需将每个新样本和它的增量做看作新的累。

自监督类型+自我批评的游戏机制,这样一个闭环转录就会很容易学会。

值得一提的是,这种学习特征的结构,类似于在灵长类动物的大脑中观察到的类别选择区域的结构。

作者之一曹颖表示,这个框架与此前诸多想法类似,包括预测编码、对比学习、生成模型、Transformer……

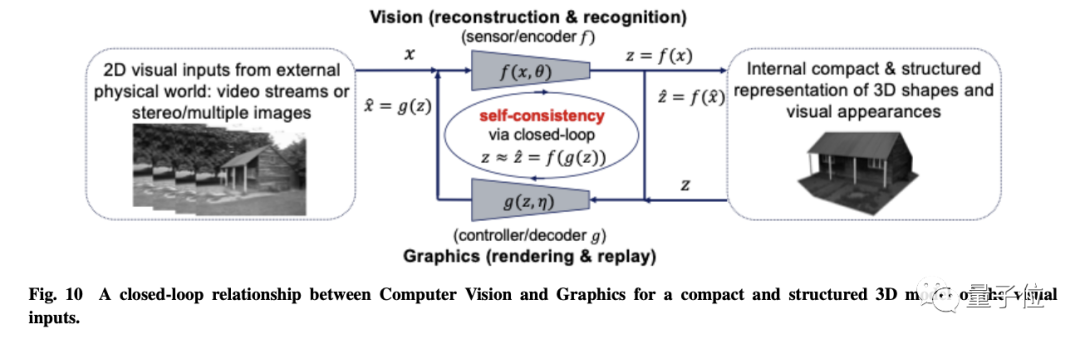

除此之外,他们还给出了些新方向,比如CV与图形学之间的闭环关系。

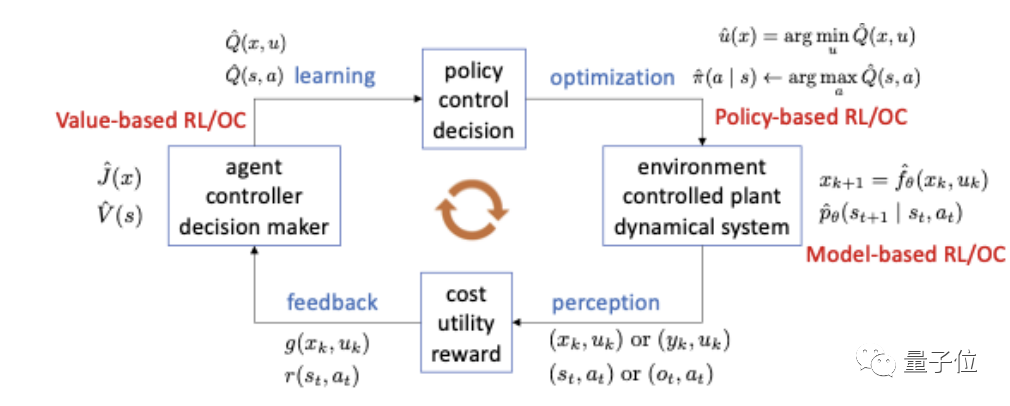

最后整合在一起,一个自主的智能体,学习某种任务的最佳策略,是将感知(反馈)、学习、优化和行动整合到一个闭环中。

它统一并解释了现代深度网络和许多人工智能实践的演变。虽然整个文章主要以视觉数据的建模为例。

但研究人员相信这两个原则,将统一对广泛自主智能系统的理解,并为理解大脑提供一个框架。

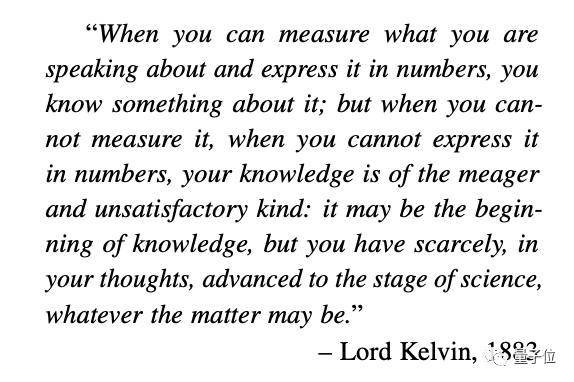

最后,他们还以热力学之父的话作为结尾。

大致意思是只有当你能测量,并用数字来表示你所讲的东西时,你就对它有了解;如若不然,它可能是知识的开始,但在你的思想中,你几乎没有推进到科学的阶段。

One More Thing

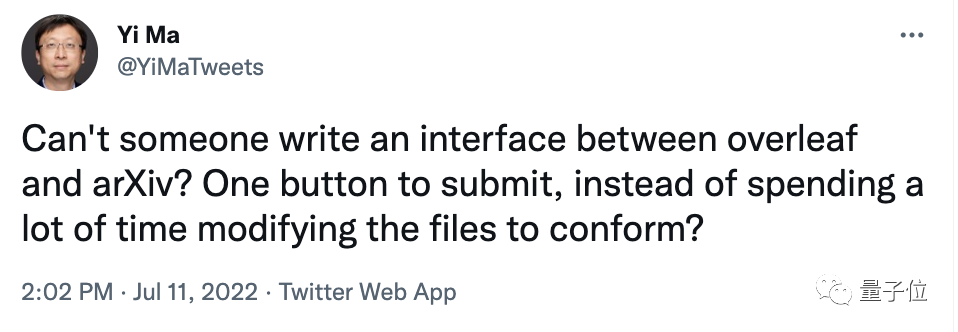

有意思的是,就在提交arXiv之际,马毅教授还在网络上求助:

有人就不能写一个接口吗?一键提交论文的那种。而不是花费大量时间在修改论文。

网友们也纷纷支招:使用LaTeX 编译器,而不是PdfLaTeX。

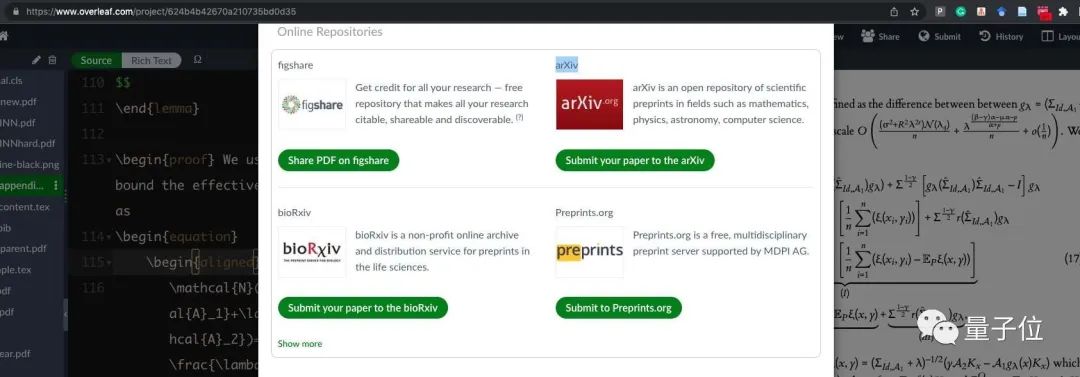

还有人直接上图。

好了,感兴趣的旁友可戳下方链接了解更多~

论文链接:

https://arxiv.org/abs/2207.04630

参考链接:

[1]https://weibo.com/u/3235040884?profile_ftype=1&is_all=1#1657668935671

[2]https://twitter.com/YiMaTweets/status/1546703643692384256

[3]https://twitter.com/doristsao/status/1546722505091534851

扫码加入我们

个人会员:1000元/届(5年)

学生会员:50元/届(5年)

终身会员:2000元

ai论文写作

ai论文写作

评论前必须登录!

立即登录 注册