文章太长,ChatGPT没法阅读?

拆分太累,写论文效率大打折扣?

使用它可以突破限制:轻松将大文本块发送到 ChatGPT!

你有没有收到过来自 ChatGPT 的Error,说发送的数据太多,需要发送更短的文本?

如果答案是,那么赶紧捡起这款ChatGPT Prompts分拆神器吧,其实原理非常简单,但是对于效率的提升绝对是事半功倍。

因为,亲测有效!

相信大家都知道给ChatGPT输入大段文字时,ChatGPT会因为限制而无法处理。尤其是GPT4之前的版本,比如像下面这样:

所以你不得不将文字拆解开来,并且配上相应的Prompts来解释。

有时候你越解释,ChatGPT越不理解,导致花费大量的时间在文字的编辑和处理上,没有办法和ChatGPT进行高效地沟通。

如果你也经常碰到这样的问题,那么,这个工具就太值得你拥有了!

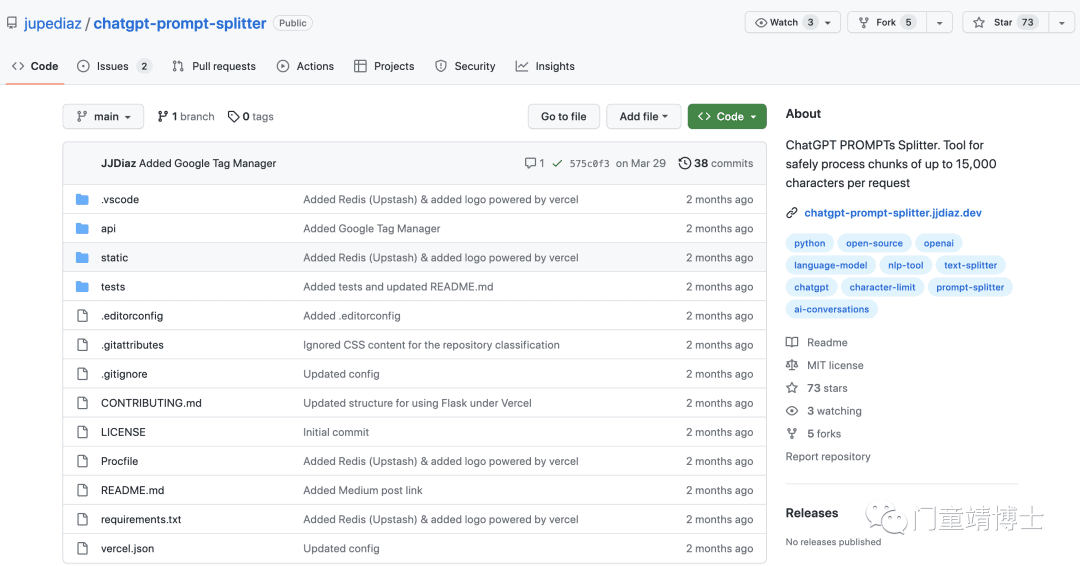

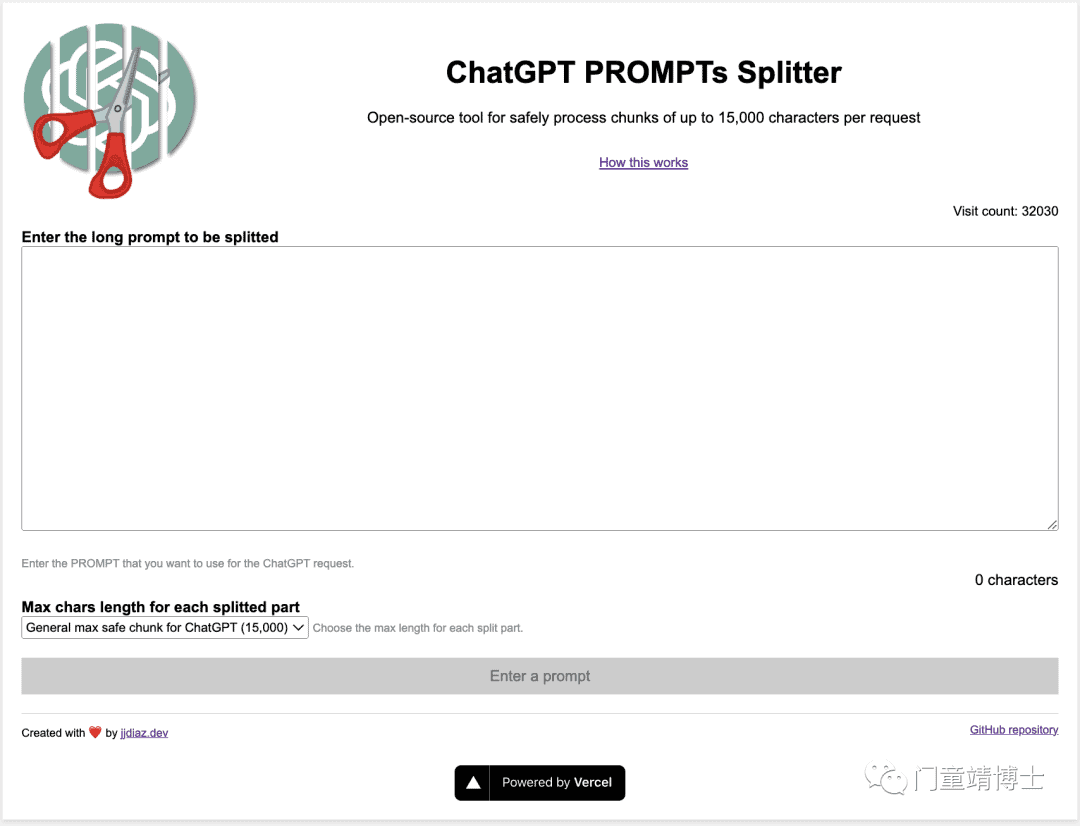

1. Prompts Splitter

ChatGPT PROMPTs Splitter 是一个开源工具,旨在帮助你将大量上下文数据提供给发送到 ChatGPT 的指令(Prompts),并将其分成更小的块,并根据一种方法处理所有块的接收 ChatGPT(或其他有字符限制的语言模型)。

该工具确保默认情况下将文本分为每个请求最多 15,000 个字符的安全块,但可以根据需要进行自定义。

该工具包括一个易于使用的 Web 界面,用于输入长提示、选择每个块的最大长度以及单独复制块以将它们粘贴到 ChatGPT。

工作原理

该工具使用简单的算法将文本拆分为更小的块。该算法基于以下规则:

1. 根据指定的最大长度将提示分成块。

2. 在第一个chunk中添加信息,指示AI接收和确认chunk的过程,等待chunk传输完成后再处理后续请求。

测试验证

我们以Hugging GPT这篇论文为例,测试一下该工具的能力如何~

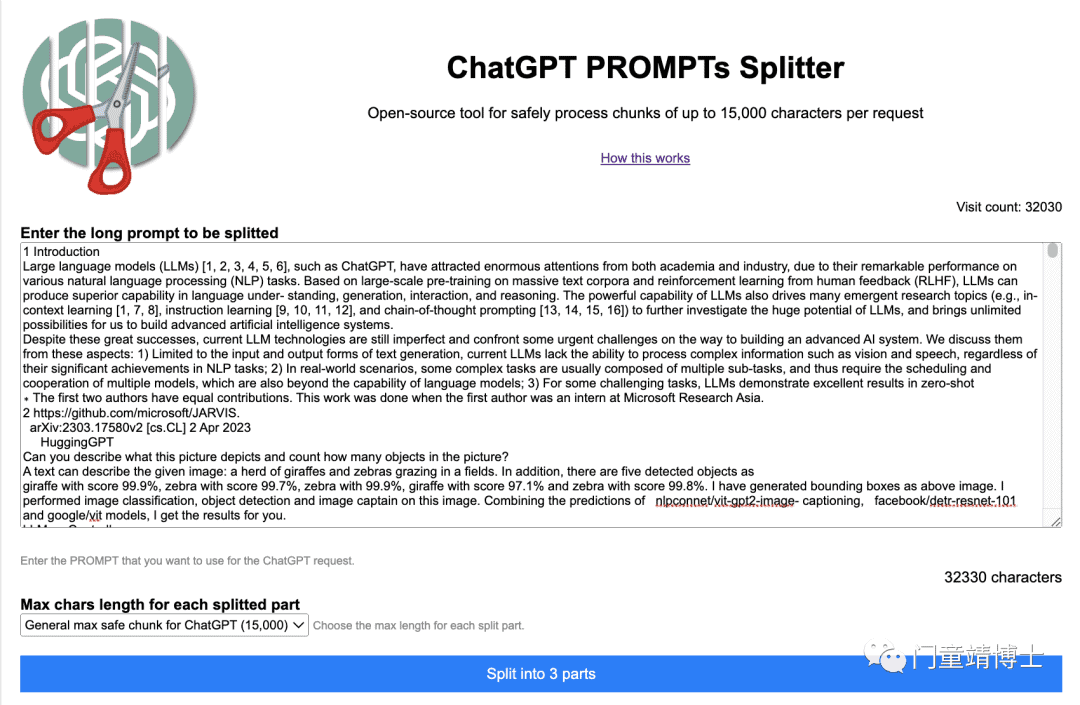

1. 首先,将Introduction,Related Works和Methodology部分输入:

2. 该系统对文字进行拆分后,得到如下结果,主要两个部分,一个是提前给ChatGPT的说明,另一个是将文字拆分为15000为一块的文字块:

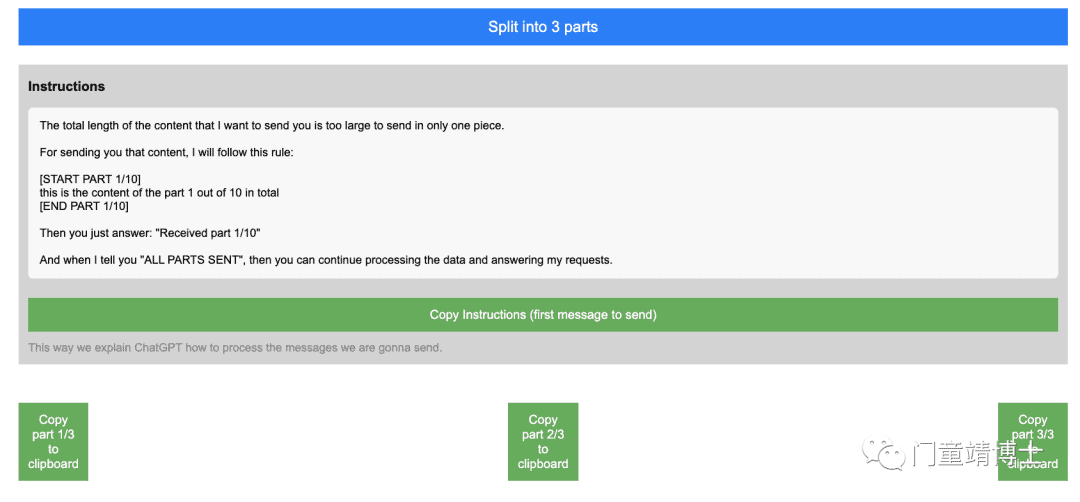

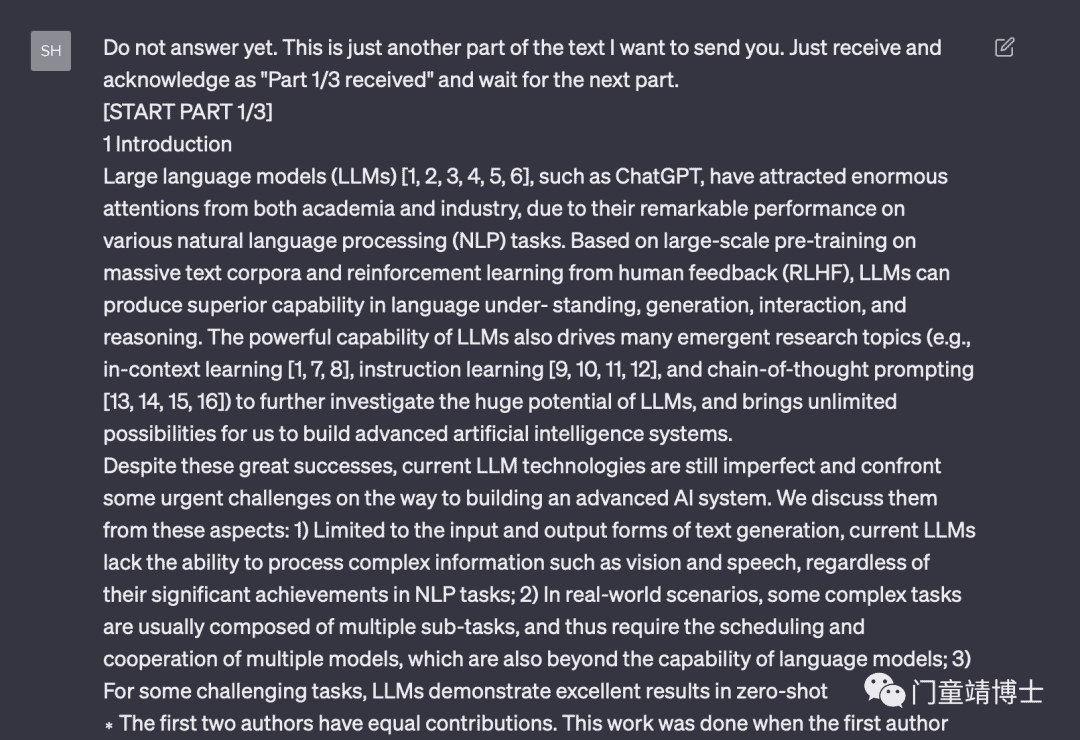

3. 这个是该工具生成的提示语句,首先需要将如下指令输入至ChatGPT,其实就是定好沟通规矩:

The total length of the content that I want to send you is too large to send in only one piece. For sending you that content, I will follow this rule: [START PART 1/10]this is the content of the part 1 out of 10 in total[END PART 1/10] Then you just answer: "Received part 1/10" And when I tell you "ALL PARTS SENT", then you can continue processing the data and answering my requests.

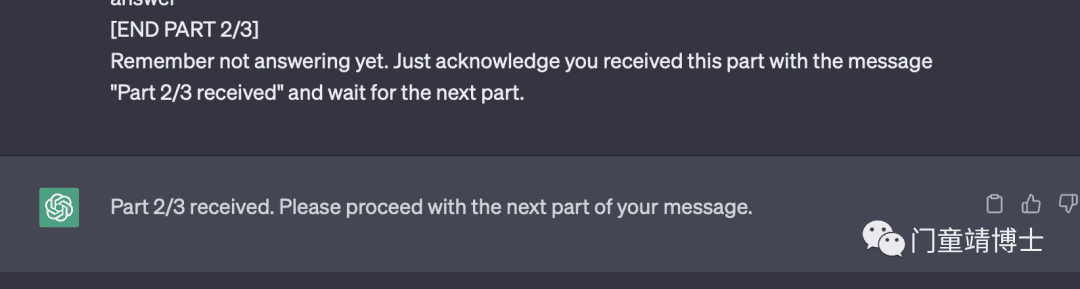

接下来我们可以复制粘贴相应的块内容,到ChatGPT对话框,然后ChatGPT接收后理解了。

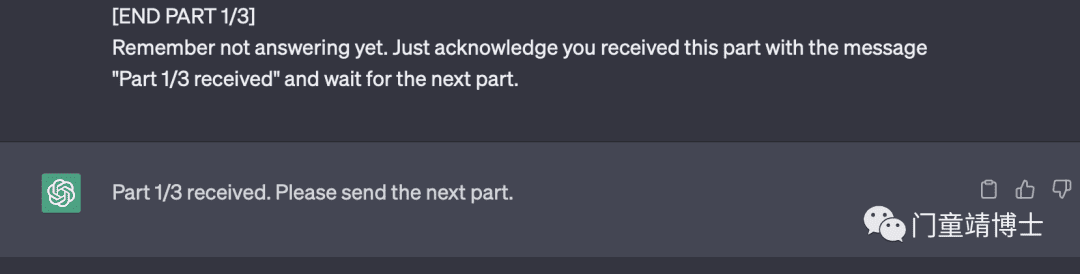

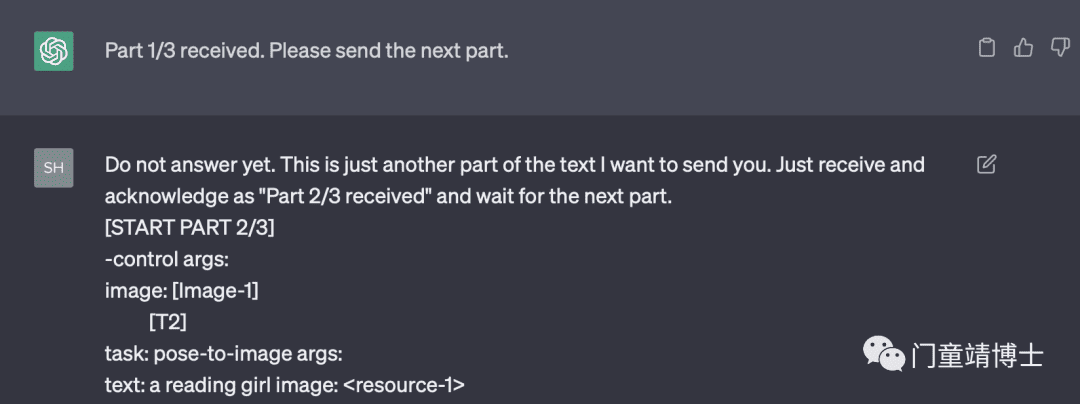

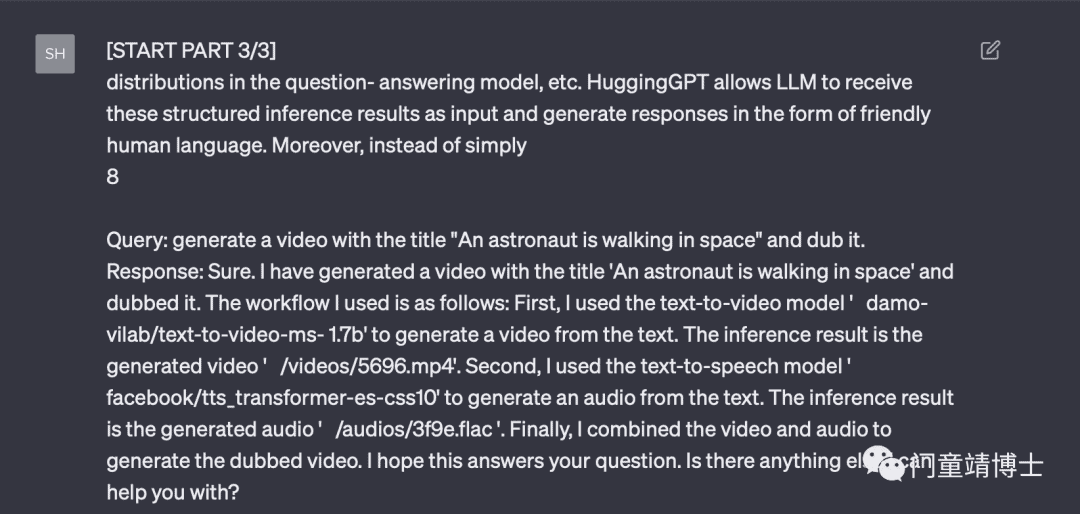

4. 输入相应的子文字块给ChatGPT,从第一个文字块开始:

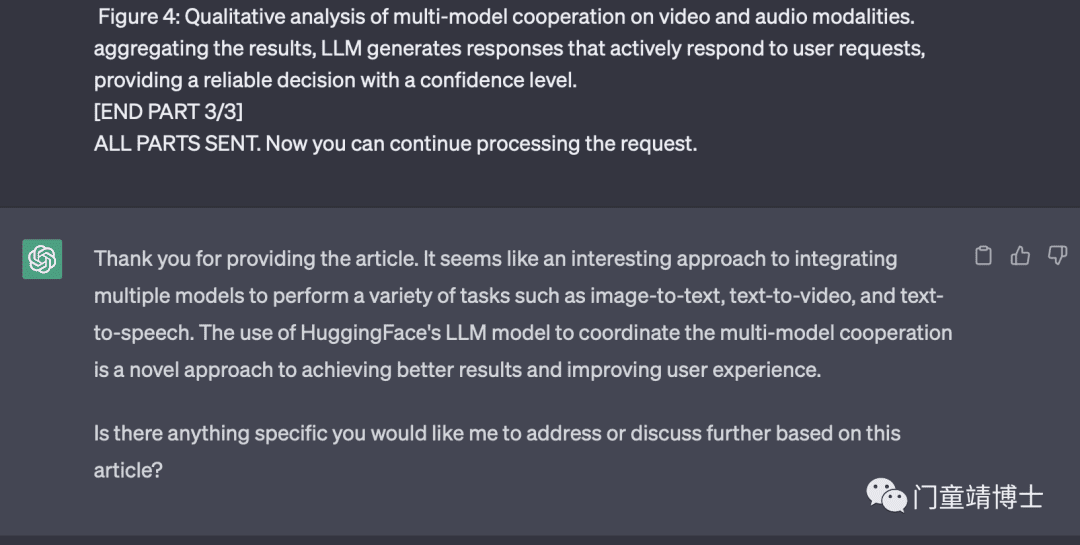

5. 进一步将剩余的文字块输入完,ChatGPT也给出了相应的反馈如下,可以从反馈中看到,ChatGPT已经理解能够理解该文章的三段内容,并且询问我们对于该文章什么问题需要咨询~

Thank you for providing the article. It seems like an interesting approach to integrating multiple models to perform a variety of tasks such as image-to-text, text-to-video, and text-to-speech. The use of HuggingFace’s LLM model to coordinate the multi-model cooperation is a novel approach to achieving better results and improving user experience.

Is there anything specific you would like me to address or discuss further based on this article?

感谢您提供文章。这似乎是一种有趣的方法,可以集成多个模型来执行各种任务,例如图像到文本、文本到视频和文本到语音。 使用 HuggingFace 的 LLM 模型来协调多模型协作是一种获得更好结果和改善用户体验的新方法。

基于这篇文章,您有什么具体的希望我解决或进一步讨论的吗?

大功告成!

我们已经使用 ChatGPT Prompt Splitter 成功地将长 PROMPT 拆分为更小、易于管理的块。

接下来就可以根据自身的需求来对其进行提问和沟通了!

正式开始自己的任务

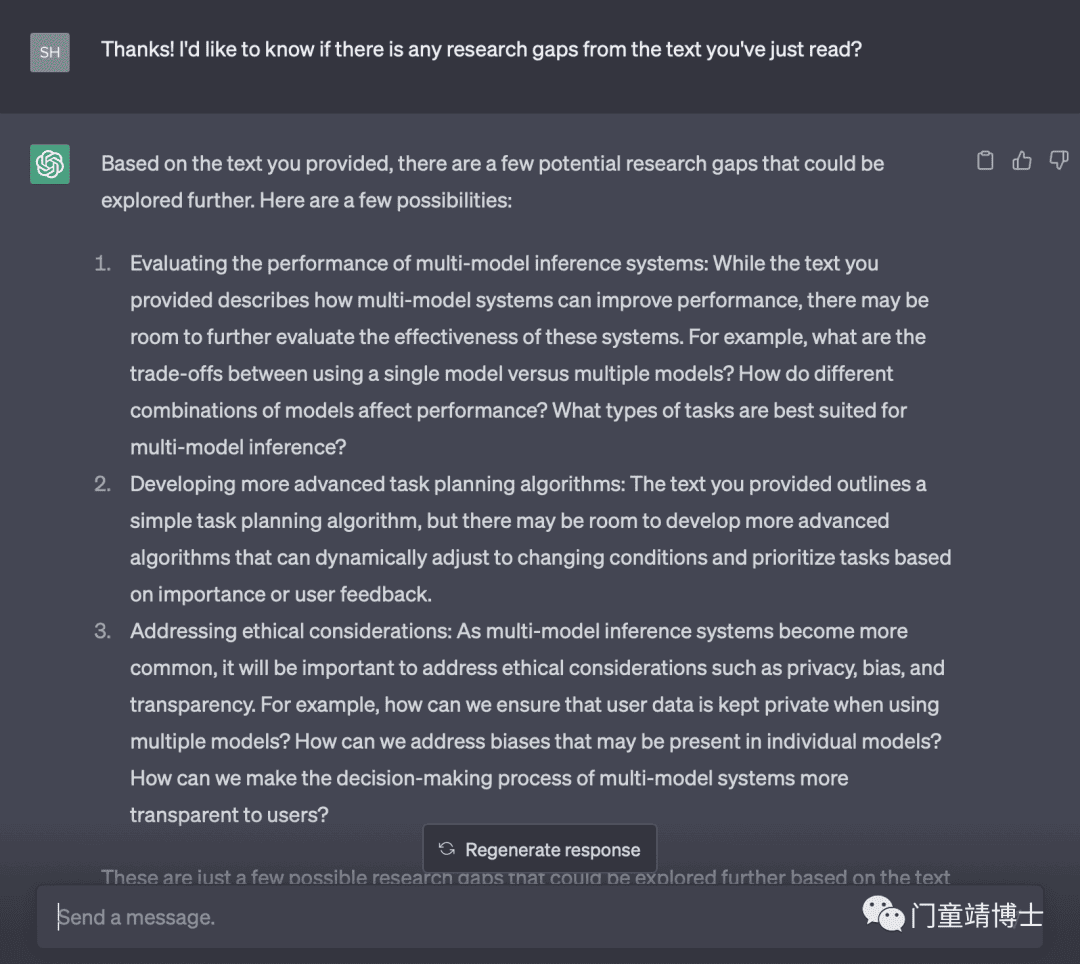

接下来,开始着手我们自己的任务了,基于这篇文章的内容,有哪些值得研究的Research Gaps可用我们继续研究呢?

ChatGPT的回答如下:

根据您提供的文本,有一些潜在的研究空白可以进一步探索。这里有几种可能性:

评估多模型推理系统的性能:虽然您提供的文本描述了多模型系统如何提高性能,但可能还有进一步评估这些系统有效性的空间。例如,使用单一模型与使用多个模型之间的权衡是什么?模型的不同组合如何影响性能?什么类型的任务最适合多模型推理?

开发更高级的任务规划算法:您提供的文本概述了一个简单的任务规划算法,但可能还有开发更高级算法的空间,这些算法可以动态调整以适应不断变化的条件并根据重要性或用户反馈确定任务的优先级。

解决伦理问题:随着多模型推理系统变得越来越普遍,解决隐私、偏见和透明度等伦理问题将变得很重要。例如,在使用多个模型时,我们如何确保用户数据的私密性?我们如何解决个别模型中可能存在的偏差?如何让多模型系统的决策过程对用户更加透明?

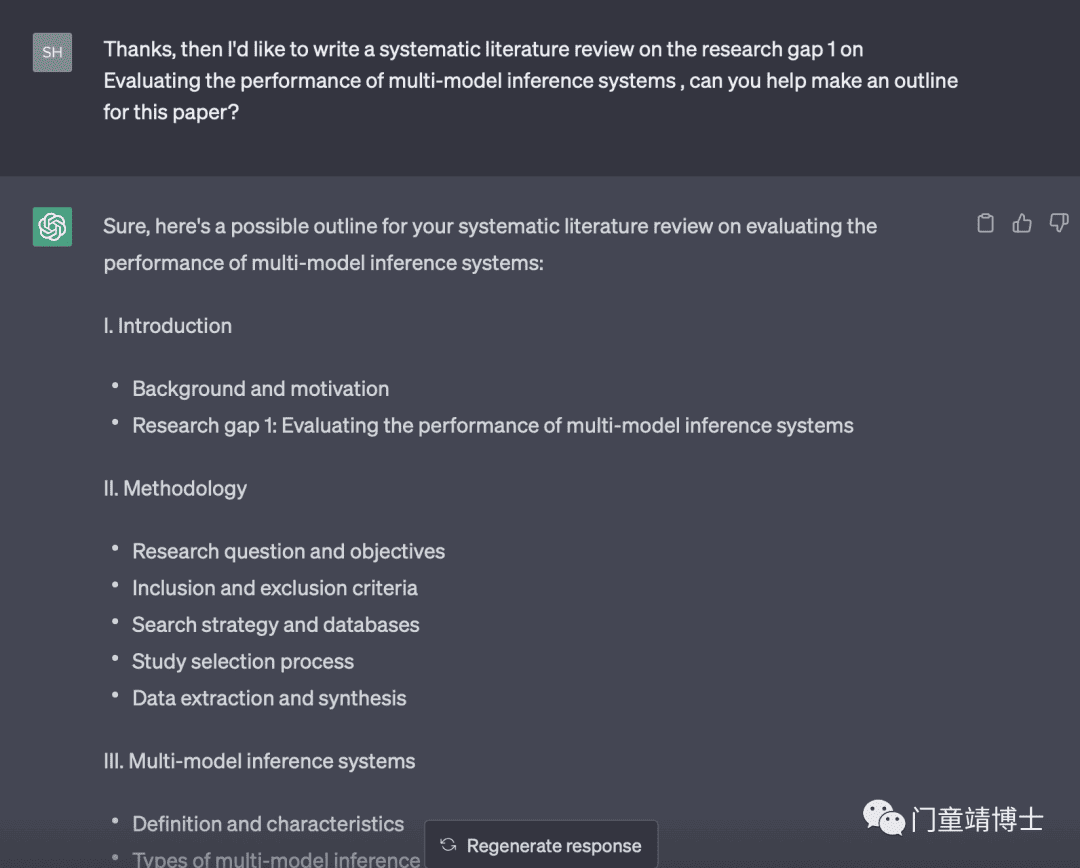

那么能否基于Research Gap1 写一篇文献综述呢?请帮我列一下大纲:

具体也可以参考我之前写的一篇文章《#ChatGPT一小时完成文献综述(Systematic Literature Review)!》

一、简介

背景和动机

研究差距 1:评估多模型推理系统的性能

二。方法

研究问题和目标

纳入和排除标准

搜索策略和数据库

研究选择过程

数据提取和综合

三、 多模型推理系统

定义和特征

多模型推理系统的类型

优势与挑战

四、 绩效评估方法

评估多模型推理系统的指标

实验设计和评估方案

案例研究和例子

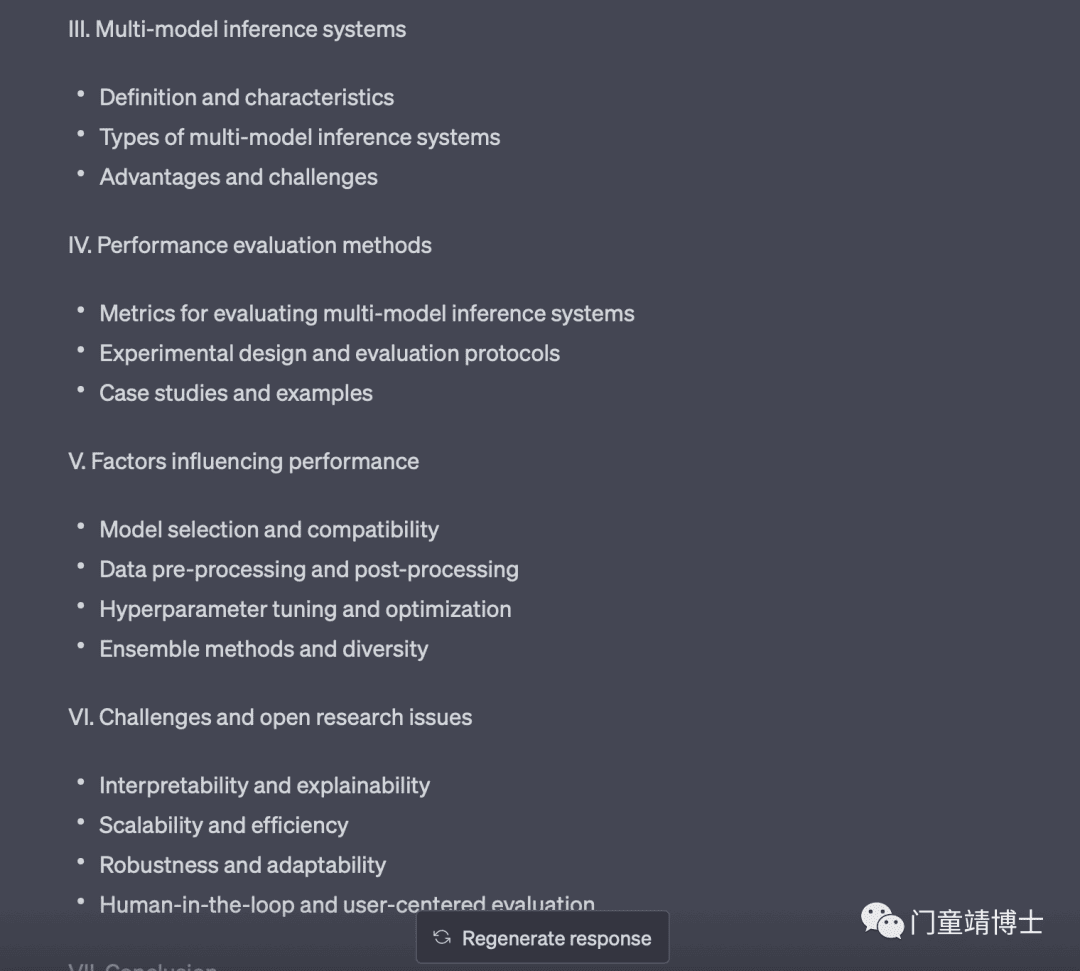

五、影响绩效的因素

选型与兼容性

数据预处理和后处理

超参数调整和优化

集成方法和多样性

六。挑战和开放研究问题

可解释性和可解释性

可扩展性和效率

鲁棒性和适应性

以人为本和以用户为中心的评估

七。结论

主要发现和贡献摘要

对未来研究和实践的启示

局限性和进一步改进的方向

八。参考

至此,你也可以开始自己的Prompts拆分之旅,看看能否对论文写作效率有所提升!

参考文献:

[1]https://chatgpt-prompt-splitter.jjdiaz.dev/

[2]https://github.com/jupediaz/chatgpt-prompt-splitter

[2]https://medium.com/@josediazmoreno/break-the-limits-send-large-text-blocks-to-chatgpt-with-ease-6824b86d3270

HAVE FUN!

ai论文写作

ai论文写作

评论前必须登录!

立即登录 注册